“ChatGPT”可能是从2022年底至今,最为出圈的科技热词之一。GPT是Generative Pre-trained Transformer的缩写,示意天生型预训练变换模子。这个由OpenAI研发的语言模子激起了人们对AI手艺新一轮的热情。人们与ChatGPT泛论古今,请它翻译文本、编代码、写文章。(p.s.猜猜看,这篇文章是不是ChatGPT写的?)

爆火背后,我们试图对ChatGPT有更多明晰。若是说以ChatGPT为代表的AIGC(AI-generated content,AI生产内容)本质上是手艺革命,那么,脱离了对手艺的认知来讨论这个议题,难免会泛起误差。

在这篇讲述,我们会先梳理ChatGPT生长的历史沿革:它从那里来,到底是什么手艺在驱动它向前。我们的思索也会围绕人们对它的讨论而睁开:它能火多久,有时机成为“人类大脑”或通用人工智能(AGI)吗?同样主要地,我们会把落点放在创投行业,来探讨与AIGC相关的创业及投资时机。

/ 01 /

火爆了的ChatGPT,到底是什么?

▍ChatGPT的本源——语言模子

ChatGPT着实是一种语言模子。依据OpenAI官方的先容,ChatGPT已具备明晰和天生人类语言文本的能力,可以跟人类轻松对话。

图片泉源:OpenAI官网

人类的语言异常庞大,而比语言更庞大的,是缔造语言的头脑。人们曾经试图给语言建模,然则一直没有取得显著性的乐成。而ChatGPT则为语言建模打开了新的窗口,这也是它的降生惊动全球的缘故原由之一。

Wikipedia对语言模子的界说是:“单词序列的概率漫衍,给定任何长度为m的单词序列,语言模子通过对语言的文本语料库举行训练,来天生概率漫衍”。斯坦福的果然课说得更为直接:“语言模子就是用来展望下一个泛起的词的概率”。(斯坦福的界说归纳综合了GPT的焦点原理,而不是BERT类语言模子的原理。或许这能从侧面反映,人们已将GPT接纳的手艺蹊径,视为主流语言模子蹊径。)

GPT系列的语言模子,其主要目的是展望下一个单词。好比,前半句是“the students opened their”,语言模子要展望的是下一个单词泛起“books”或者“laptops”或者“exams”等词汇的概率划分是若干。语言模子的手艺原理虽然简朴,然则却衍生出了ChatGPT这样智能、有庞大应用场景的产物。

ChatGPT可能是当前最乐成的大型语言模子,我们正在履历iPhone Moment

ChatGPT可能是现在最乐成的语言模子,人们把当下这个ChatGPT降生的时刻称为“iPhone moment”。

GPT是Generative Pre-trained Transformer 的缩写。Transformer神经网络算法是当前最新的一种算法模子,我们会在下文睁开。GPT系列模子都是语言模子,是新型神经网络算法、新型模子训练方式加上海量数据算力多重因素叠加产出的功效。

GPT模子有几个主干版本,从 GPT-1、GPT-2、GPT-3演进到最新的GPT-3.5版本。

当下人们使用的ChatGPT是在3.5版本的基础上,专门针对人类需求做了大量微调,指导模子输出更相符人类需求的效果。这让GPT模子逐渐“社会化”,变得更像人。经由微调的ChatGPT“情商”变高了,不再只是个话痨,也不再那么口无遮拦。

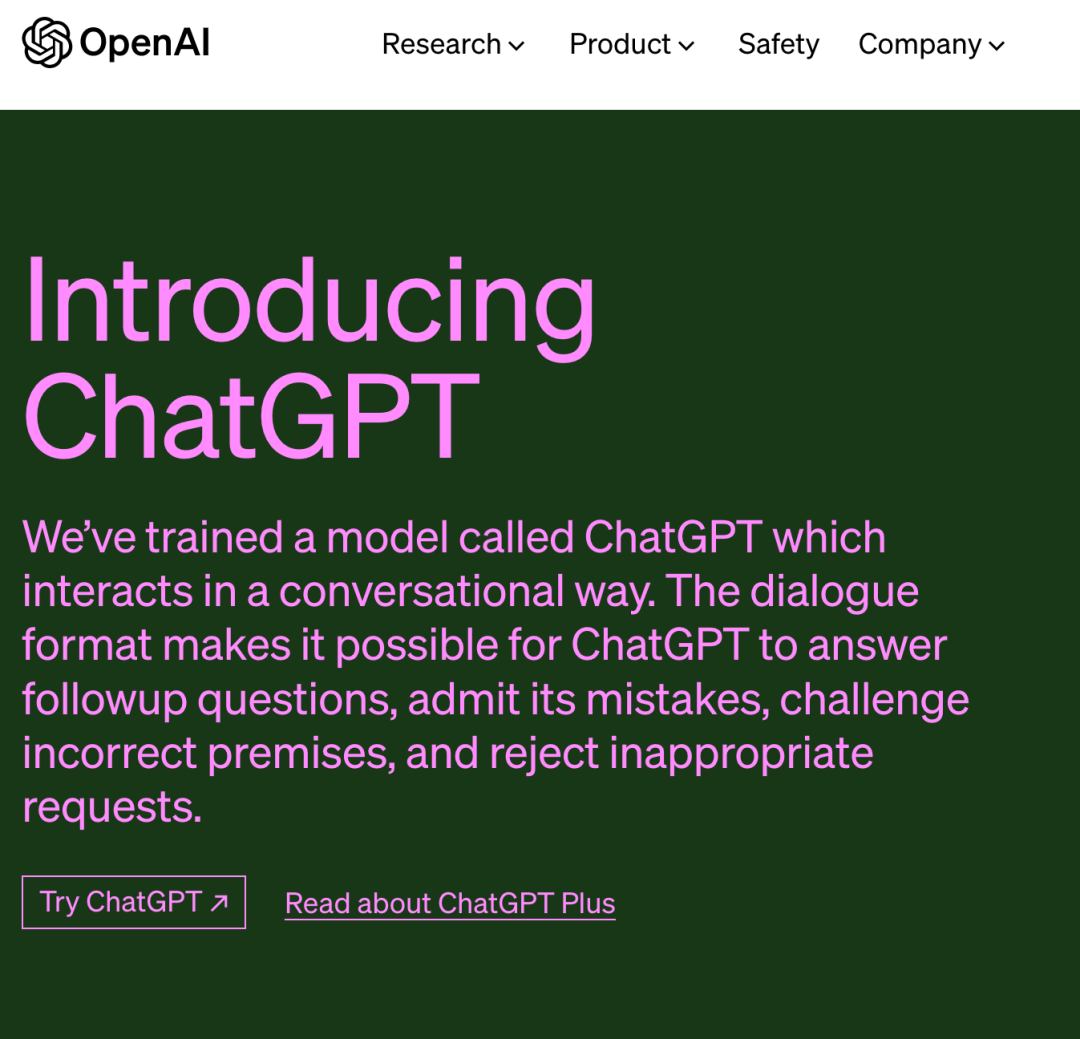

ChatGPT的降生历程

图片泉源:微信民众号@AI语者

在ChatGPT问世之前,GPT模子履历了怎样的生长历程?

2017年6月,Google公布Transformer这一神经网络算法模子,它为大型语言模子的生长奠基了基础。

一年之后,OpenAI公司推出了GPT-1,GPT-1接纳语言模子预训练 微调训练两阶段的训练方式,在问答和知识推理、语义相似度、分类等义务中,取得了还不错的语言义务执行效果。

2018年10月,Google推出另一个语言模子——BERT,效果跨越GPT-1。

图片泉源:知乎@雅正冲蛋

GPT和BERT都是基于Transformer衍生出的算法,但在手艺蹊径上各有着重。GPT基于 Transformer 右边部门,叫解码器。BERT基于 Transformer 的左边部门,叫编码器。

GPT的手艺原理是展望下一个词,你可以看作是“文字接龙”,你写出前面的句子,由GPT来猜下一个词。但BERT更像是“完形填空”,其手艺原理是把一句话中某个词给遮盖住,然后请BERT来猜。

解码器善于创作,编码器善于明晰,那时它们要做的更多是屏障语言模子(Masked LM,类似“完形填空”)、相邻句子判断(Next Sentence Prediction,判断句子是否能相连)这类偏阅读明晰的义务,因此BERT占了优势。

2019年,GPT-2公布,它接纳15亿个参数的Transformer解码器,在那时是个对照大的模子。相比BERT,OpenAI研究职员发现,GPT-2预训练的语言模子无需微调训练,可直接执行多种下游义务。这个发现坚定了研究职员沿着现有手艺蹊径,继续研发的刻意。

2020年5月,GPT-3降生,它接纳了史无前例的1750亿参数的Transformer解码器,用了靠近5000亿单词的文本训练数据。整个训练历程可以说是“鼎力出事业”,让GPT-3在文字天生方面实现质的飞跃。GPT-3除了可以精彩完成文字天生、翻译、问答和文本填空等语言类义务外,还“涌现”出了其他一些智能,包罗上下文学习,以及更壮大的零样本和少样本执行义务的能力,等等。

GPT-3天生的文本质量异常高,有时刻人们甚至难以区分文本到底是人类写的,照样GPT-3天生的。

基于GPT-3,已经衍生出许多应用,人们用GPT-3来创作种种类型的文本。有人用它写了一篇新闻,被某热门新闻点评网站排到头部。一家名为Jasper的公司行使GPT-3为企业提供商业文本写作服务,2022年其收入到达9000万美元左右。

GPT-3之后,OpenAI通过增添程序代码训练和人类反馈强化学习等多种训练手段,并将主版本升级到GPT-3.5。最终,2022年11月,ChatGPT横空出世。

训练GPT-3模子的三“大”要素:算法、数据、算力

我们称GPT-3为大模子,这个“大”体现在哪些地方?

首先是算法。GPT-3接纳的是Transformer的解码器,具有1750亿个参数和2048个Token(可简朴明晰为单词,下同)的训练文本长度。

图片泉源:OpenAI团队论文

图片泉源:OpenAI团队论文

《Language Models are Few-Shot Learners》

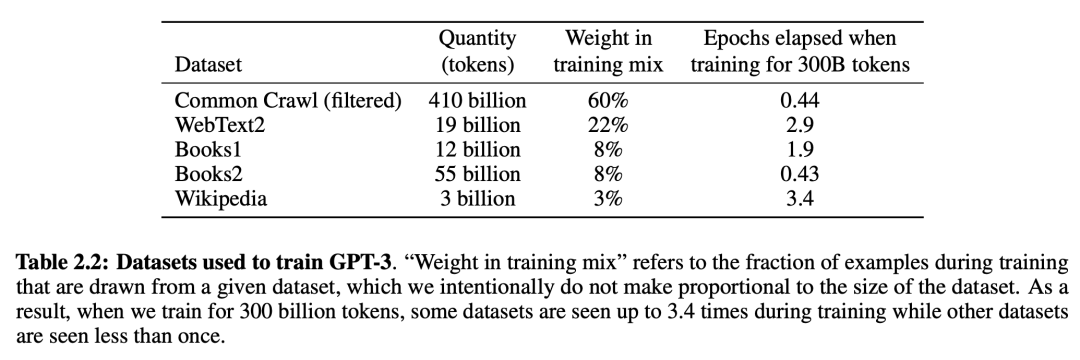

第二是数据。上图是GPT-3的训练数据,总共靠近5000亿个token的文本,主要包罗Common Crawl、Webtext2、Books1、Book2、Wikipedia等等。其中占比*的训练数据是Common Crawl,它是一个开源的数据集,抓取并保留了全球大量网页的数据。

第三是算力。据微软公布的信息, OpenAI 使用一台全球排名前5的超级盘算机系统来训练GPT-3,该系统拥有跨越28.5万个CPU焦点,1万个GPU和每秒400G的网络。据悉其训练成本约为1200万美元。

/ 02 /

人们若何看待ChatGPT?

ChatGPT降生以来,引发的讨论异常多。那么说回来,人们若何看待这个新事物,对它又有什么期待?虽然众说纷纭,有3个议题是被频仍提到的。

人们一定ChatGPT是一个称职的语言模子

首先,ChatGPT是迄今为止最乐成的人类语言模子,已经具备形式语言能力(洞悉语言的规则模式等知识)。

ChatGPT具备明晰和天生人类语言文本的能力,可跟人类轻松对话。它用数据驱动的大型神经网络的盘算方式,某种水平上解码了人类语言的内部纪律。这个内部纪律不是某种公式,而是一个神秘、暂不被人类明晰的权重参数矩阵。

以前,人们以为算法模子若是仅靠输入文本,很难获取关于语言的知识。但现在,ChatGPT可以从文本中直接学习语言的条理结构和抽象种别等,这是一种无监视学习的能力。

此外,ChatGPT也不只是个话痨。它可以写作文、创作诗歌、撰写商业文本、翻译、做阅读明晰、代码明晰和天生等。可以说,作为一个语言模子,ChatGPT已经对照称职。

▍人们期待ChatGPT具有头脑能力

人们对ChatGPT的期望不仅仅是语言模子,人们甚至期待ChatGPT成为一个头脑机械,生长出功效语言能力(用语言思索和做事的能力)。

ChatGPT“涌现”出一些智能,包罗上下文学习(明晰和学习人类对话输入文字的能力)、天下知识抽象(例如事实性知识和知识)、执行泛化义务(包罗没有做过的新义务)、庞大推理等。然而,当前ChatGPT的这些功效都还不算壮大,失足甚至溃逃时有发生。

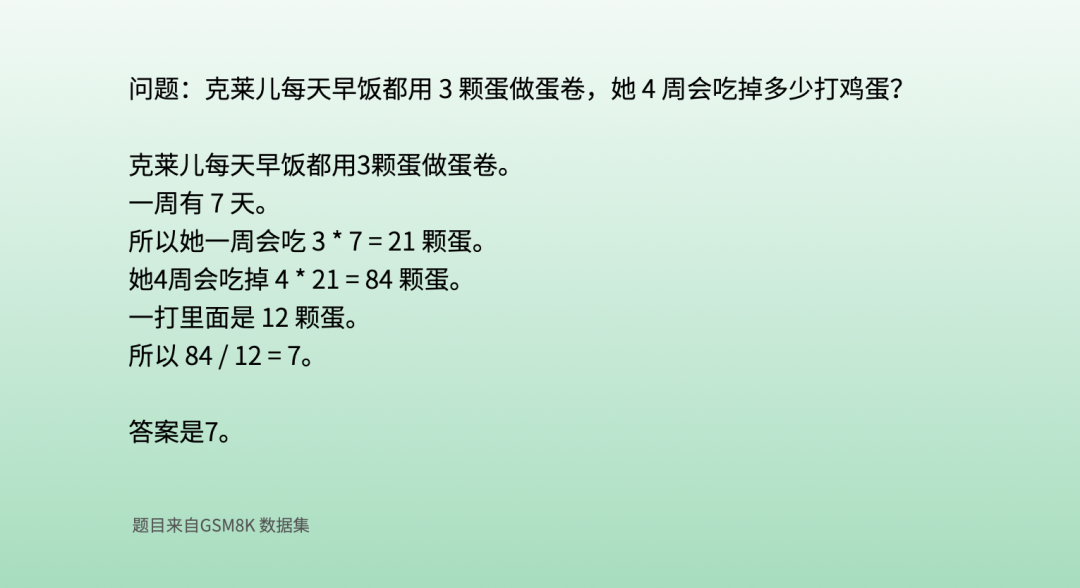

当前,人们在头脑机械偏向的探索有许多,例若有一种借助头脑链(Chain of Thought)的方式,试图指导或者优化语言模子展现出庞大的推理能力。这些研究偏向的希望仍在延续。

上图展示的是,一位科研职员在跟ChatGPT的对话中,通太过步骤提醒指导的示例训练(指导历程未展示),使ChatGPT展现出分步骤思索和盘算的能力。据剖析,ChatGPT的这个能力来自GPT-3.5模子自己,头脑链训练方式只是让它意识到应该用这种方式来思索和回覆问题。整个历程有点类似先生指点学生做题。

虽然这道题对于10岁的孩子来说很容易,但对语言模子来说却很难,主要是由于数学和语言夹杂在一起。这类问题只是最先,当前头脑链的前沿科研事情已经转向更有难度的问题,例如高中、大学,甚至是国际数学奥林匹克问题。

加利福尼亚大学洛杉矶分校(UCLA)近期的一篇论文发现,ChatGPT似乎展现出了类比推理的能力。

什么叫类比推理?推理分三种,包罗演绎、归纳、类比。“类比推理通常被视为人类抽象和归纳综合能力的典型能力。在普遍的问题类型中,ChatGPT到达或者逾越人类水平...显示出这种零样本类比推理的能力。”

然而,ChatGPT的推理能力因其对天下缺乏物理明晰而受限,由于它仅仅依赖文本输入,缺少视觉(图像和视频)、声音、嗅觉等多模态数据输入。文本对天下的物理形貌是有限的,好比你很难通过文字形貌清晰一间屋子里差异物品的位置详细,相反,看一张关于这间屋子的图片,物品的位置信息就一目了然。

听说GPT-4将于2023年公布,届时会加入视觉等多模态数据输入,这将有望进一步提升它的智能。

对于ChatGPT能否成为“人类大脑”或通用人工智能,人们持有伟大争议

现在,针对ChatGPT是否能够酿成“人类大脑”或者通用人工智能(AGI),争议还异常大。Yan Lecun是深度学习的三巨头之一,他也是Meta(原Facebook)公司的首席AI科学家。他以为机械和人类纷歧样,人类会在心智内里构建一个虚拟天下,举行推理和模拟,这点现在机械做不到。

著名语言学家乔姆斯基在2019年的一次采访中提到,深度学习更偏工程,有点像推土机,可以使用,但它没有能力告诉你人类语言的任何事情。(注:ChatGPT这类语言模子可以输出很精彩的文本,然则我们没有确凿证据证实它真正掌握了语言的纪律,固然也有可能是它掌握了纪律,但人类无法明晰。)

Kyle Mahowald等学者以为,“善于语言” 未必 “善于思索”。虽然人类的语言和头脑是不能星散的,但专⻔处置语言的人脑区域,与卖力影象、推理和社交技术的人脑区域是离开的。因此不应该对语言模子有过多期望。

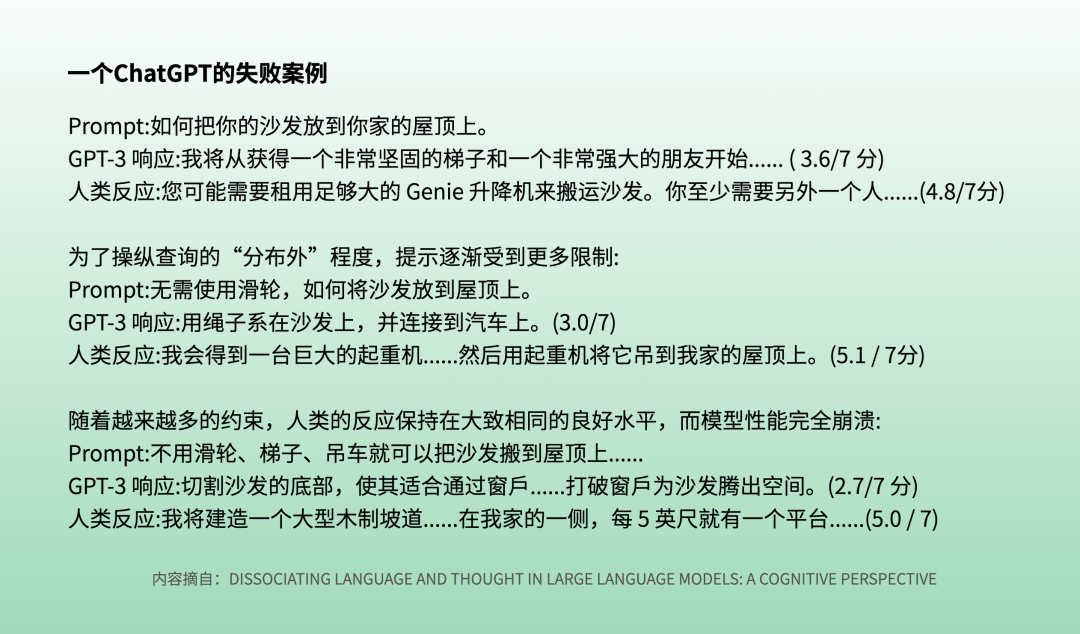

Kyle Mahowald提到了一个GPT-3没能明晰的失败案例:怎么把沙发放到你家屋顶上。

就像我们在上文提到的,屋顶、沙发、起重机等更偏天下的物理知识,对于人类来说,很容易就想到用种种设施把沙发放到屋顶上去,但你很难让ChatGPT明晰这样的操作思绪。这个例子也说明天下物理知识的输入,稀奇是视觉等多模态数据输入的主要性。

/ 03 /

背后的手艺和发现很精彩,

也尚有许多生长空间

讲完ChatGPT事实是什么,我们再来讲一下背后的手艺。

我们在上文提到,ChatGPT相当于用“文字接龙”这样简朴的手艺原理来训练和使用语言模子,从而实现跟人类的高质量智能文本对话。这个手艺原理,理论上是有升级和改善时机的,从而可能到达更好的效果。

在神经网络参数目方面,业界有人以为有优化空间,例如是否可以用参数目较小的模子到达一致效果。2048个token文本输入窗口的设计及盘算机制,也可能有优化空间。例如当前有人试图让ChatGPT写推理小说,但推理小说内里的推理线索往往不易察觉且距离较远(例如好几个章节之前的一个小线索),这个距离远远超出2048个token文本的窗口,若何把当前窗口之外的知识信息容纳进来,也存在优化可能。

整体而言,作为底层算法模子的Transformer在2017年6月才降生,现在还处在生长早期,在快速迭代和改善完善之中,应该尚有许多生长空间。

此外,前面提到的多模态数据输入,会给GPT-4带来什么样的能力涌现和性能提升,也是业内人士和群众翘首以待的。

人类可以从ChatGPT中学到什么关于语言的纪律?

在对人类语言的探索上,ChatGPT比以往的任何产物都走得更远更深。我们人类可以从ChatGPT身上学到什么?

Stephen wolfram这名科学家以为,人类语言可能没那么庞大,只是由于我们人类没有能力明晰和掌握其背后的纪律;而ChatGPT用基于神经网络的算法,乐成解码了人类语言的本质。

据OpenAI果然的GPT-2的论文,GPT-2的训练数据是纯英语文本(做了非英语文本过滤)。即便云云,它照样显示出一些多语言能力,而且展现出异常精彩的法英互译能力,只管只是接受了10MB左右残留的法语文本训练数据。

这个征象引发了人们的思索,当前人类在语言学习方面破费大量的时间和精神,这个学习效率是不是有提升的空间?我们能不能向语言模子学习,加倍有用率地学习人类语言?

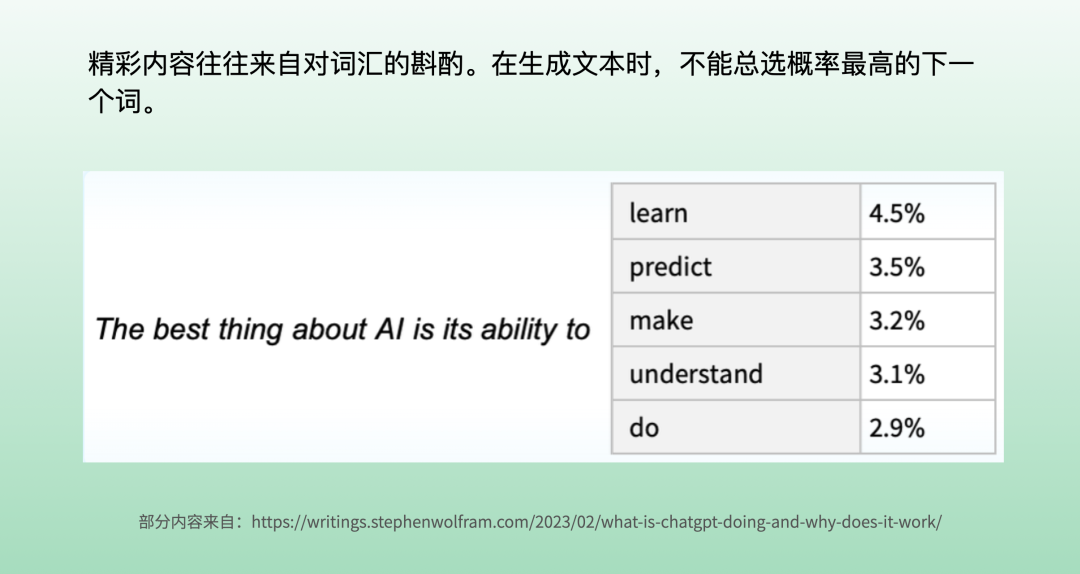

ChatGPT在天生文本时,是每次选择一个词,这个词是在语言模子给出的概率表中做出的选择。当前科研职员的发现是,若是每次都选择概率最高的词汇,理论上是*解,最后出现却往往是一篇异常通俗的文章;若是不是每次选择*解,例如随机选择排名稍微靠后一点的,却有更大时机天生一篇精彩文章。这也是个有意思的未解之谜。

以前,我们可能以为创作一篇散文或者一首诗,背后是人类全心的构想和缔造。但对于AI而言,创作意味着概率和选择,我们以为的精彩文章创作原来只是AI死板的选择历程而已。由ChatGPT反观,可强人类对语言自己的隐秘还知之甚少。

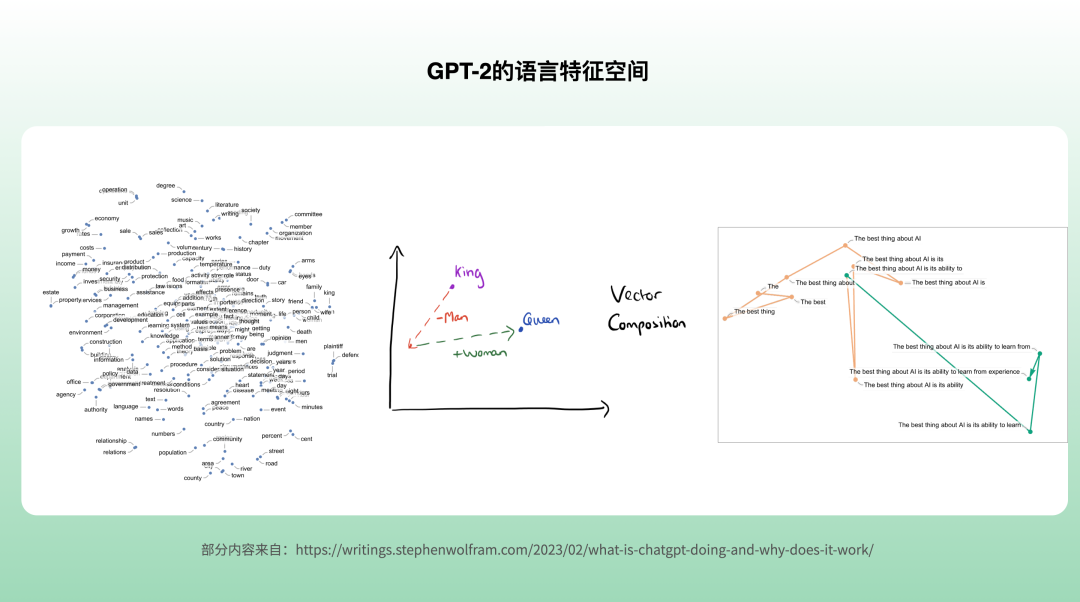

▍语言特征空间的单词漫衍

GPT把文字向量化了,确立了语言的高维特征空间,也称为隐含空间(Latent Space)。

GPT-2中每个词是一个768维的向量,GPT-3中每个词则是12288维的向量。每一个维度代表着一个属性,相当于GPT-3用1万多种属性,来形貌人类语言中的词汇特征。

Stephen wolfram试图打开人类语言的特征空间,来考察其中的纪律。他选择规模较小的GPT-2的特征空间,把它映射到人类对照容易明晰的二维空间,从中发现了许多有意思的征象。好比,crocodile鳄鱼 和 alligator短吻鳄 离得很近,苹果跟梨聚在一起,这个可能容易明晰。有趣的是,词汇之间的关系,还能从向量加减操作中反映出来,好比天子(King)的向量减去男子(man)的向量,再加上女人(woman)的向量,就酿成了女皇(Queen)的向量。

另外,他还试图在GPT-2的语言特征空间中,寻找每次天生一个句子的游走纪律,我们能从上面这个图片中,看到GPT-2是怎么在768维度的空间中游走并陆续做出下一个词的选择,然则很遗憾他还没有找到其中的纪律。虽然从高维映射到二维中丢失了许多信息,然则未来若是能连系多维空间中的向量,我们可能会发现更多关于语言的纪律。

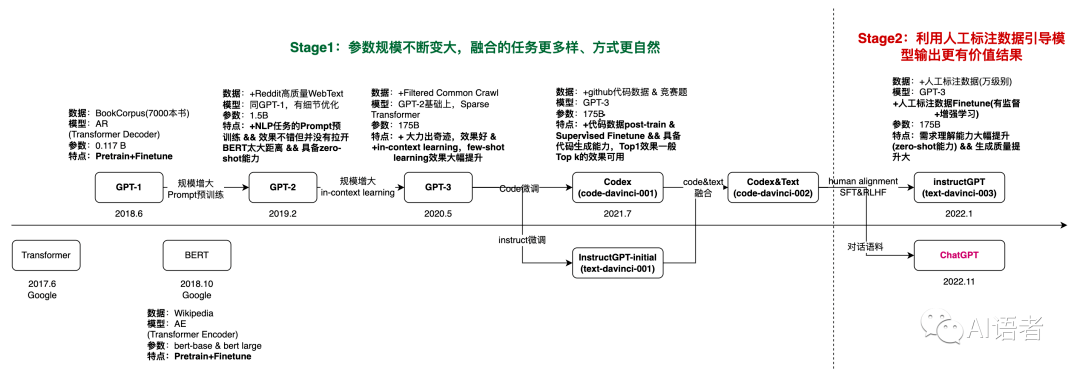

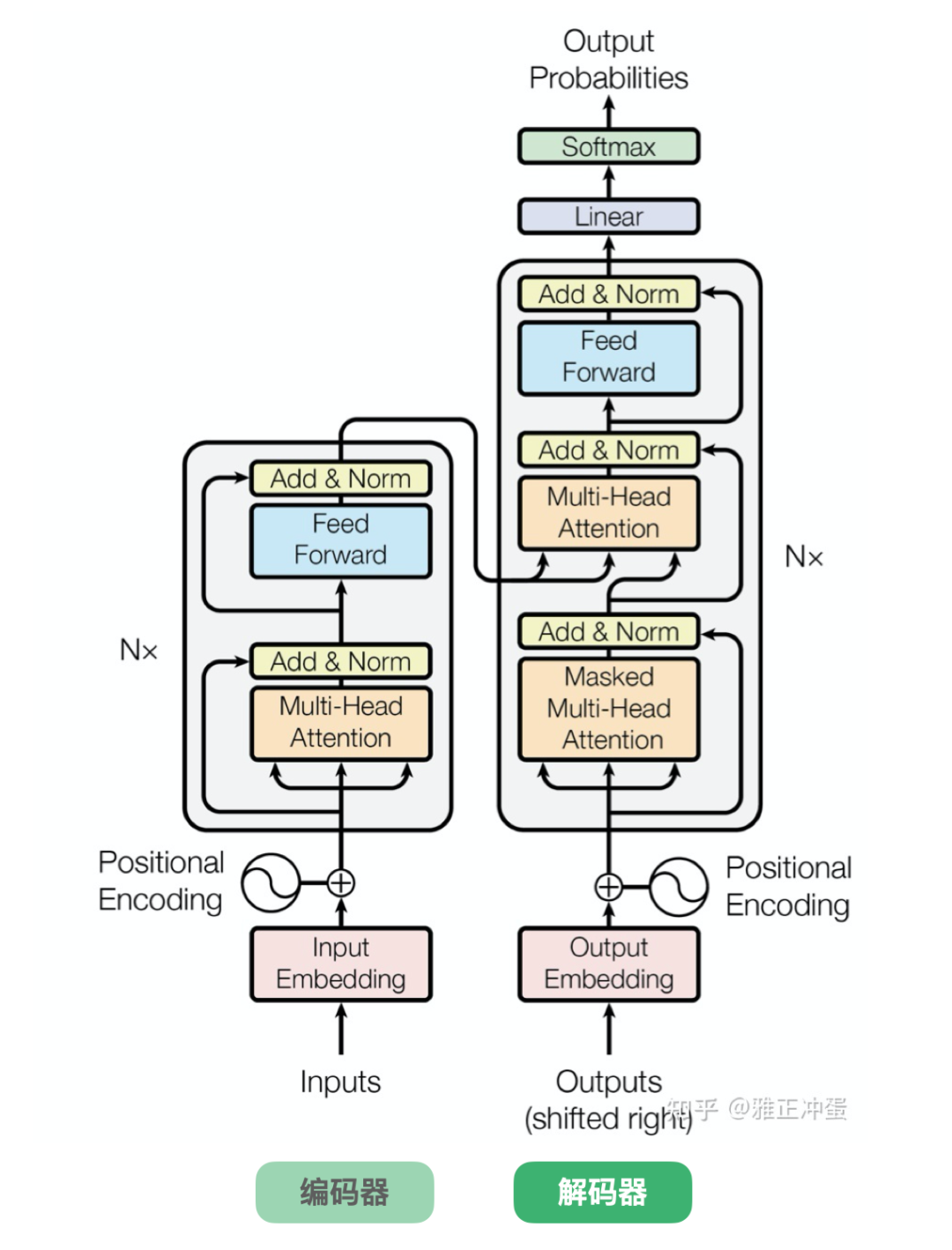

Transformer神经网络算法架构及注重力机制

2017年6月,Google揭晓了异常著名的Transformer论文,论文问题是《Attention is all you need》,意思是说你只需要注重力机制就足够了。

图片泉源:知乎@雅正冲蛋

Transformer神经网络算法架构的框图如上,如前文所述,左边部门是编码器,右边部门是解码器。Google研发的BERT用的是编码器,而OpenAI的GPT系列用的是解码器。

在AI领域,有四大类神经网络算法,包罗MLP、CNN、RNN、Transformer。MLP是多层感知器,CNN是卷积神经网络,RNN是循环神经网络。

Transformer是最新的算法模子。在一些场景中,它正在逐渐替换CNN和RNN。Transformer的特征提取能力对照强,善于长序列处置、并行盘算、多模态处置等。Transformer的注重力机制有点像人一样,选择性关注,由于资源有限,只会关注最主要的事情。

Transformer已经被普遍应用在自然语言处置、盘算机视觉以及生物科技等领域。生物科技行业用来展望卵白质三维形状的Alpha Folder算法就是基于Transformer算法模子来做的。

▍哪个模块是GPT-3储存智能的地方?

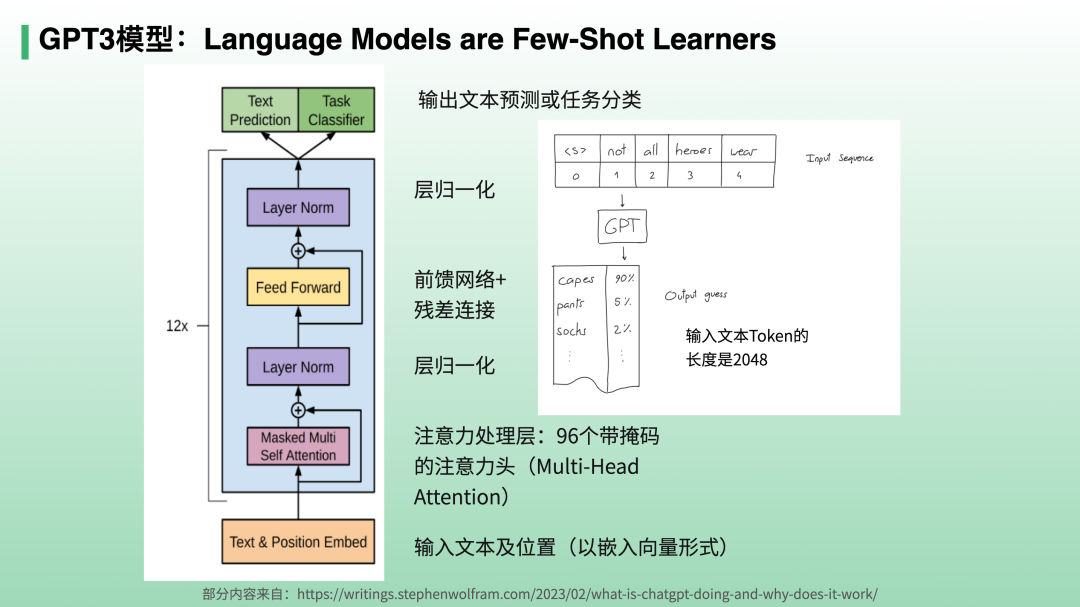

GPT-3模子公布时,OpenAI团队公布了论文《Language Models are Few-Shot Learners (语言模子是少样本学习者)》。

上图是GPT-3模子的框图,它基本上跟Transformer 的右边部门的解码器是类似的。无论是预训练照样推理(做义务),都是从框图的*部输入前面部门的文本(GPT-3模子*的长度是2048个token),然后经由12次运算,从Text prediction输出下一个词概率展望(Task Classifier是微调训练分支,在此不详述)。

一个有意思的话题是,GPT-3用1750亿个参数,去学习靠近5000亿单词的文本,显然它不是简朴地把3个单词存在1个参数中去,而是大致掌握了一些语言纪律且抽象了某些知识和能力。那么,问题来了,这些纪律、知识和能力到底存在哪些地方呢?

有学者以为,1750亿参数主要集中在框图中的注重力处置层和前馈网络层,前者的值是动态盘算的(每输入2048个token,就重新盘算一次),它们是数据相关的动态权重,由于它们会凭证数据动态转变。而前馈网络层的权重是随着训练历程而缓慢转变的,因此,有学者意料在前馈网络层中存储着GPT发现的语言纪律、知识和能力等,由于要经由12次运算,运算次数越靠后存储的信息越抽象。

Stephen wolfram把GPT-2的某个前馈网络层存储的768*768维度的权重参数矩阵提取出来,压缩到64x64尺寸,就形成了如下一张神秘的图像,代表着GPT-2总结的神秘的人类语言编码纪律及其他一些知识和能力的一部门。很好奇什么时刻科学家可以逐步解密其中的部门内容,信托对于人类提升自我能力有利益。

/ 04 /

未来,ChatGPT能否进化出自我意识?

和AI相比,自我意识和自由意志可以算作是人类最后的碉堡。

然则有一种看法以为,人类着实没有所谓的自由意志。人类有两个自我,一种是体验自我,另一种是陈述自我。体验自我,卖力相对“机械”地解读信息、作出决议;陈述自我,则卖力对体验自我的决议举行注释和表述,有时甚至会虚构故事来“诱骗”我们自己。所谓的自由意志,不外是陈述型自我给自己编的一个故事而已。

一些科学家和学者以为,理论上,我们可以组织出一个自我模拟的自指机械(Self-referential Machine),让它也具备两套系统,一个卖力执行算法,另一个则专门卖力对自我举行模拟(形貌,或者可称为在内嵌虚拟天下中模拟自我)。这种机械会显示得就“像”一个具有自我意识的系统,以至于我们可以用这样的系统来界说所谓的“自我意识”。在古代欧洲,有一种传说中的衔尾蛇,能够自己吃自己,实现延续进化。厥后,有人提出哥德尔机( Gödel Machine)的设想,以为只要程序能够模拟自身、刷新自身,那么我们就可以将其称为具有自我意识的。此外,尚有Quine程序结构、克莱因Kleene第二递归定理等也提出和支持了与之相似的假设。

我们很难预料,未来机械是否能进化出自我意识。

/ 05 /

天生式AI领域的其他希望

需要指出,当前讨论的天生式AI,跟之前的剖析式AI是有较大差其余。剖析式AI的主要能力是剖析,例如:数据剖析、趋势展望、商品推荐、图像识别等,而天生式AI主要的能力是缔造,例如:写诗、绘画、设计产物、编写代码等。

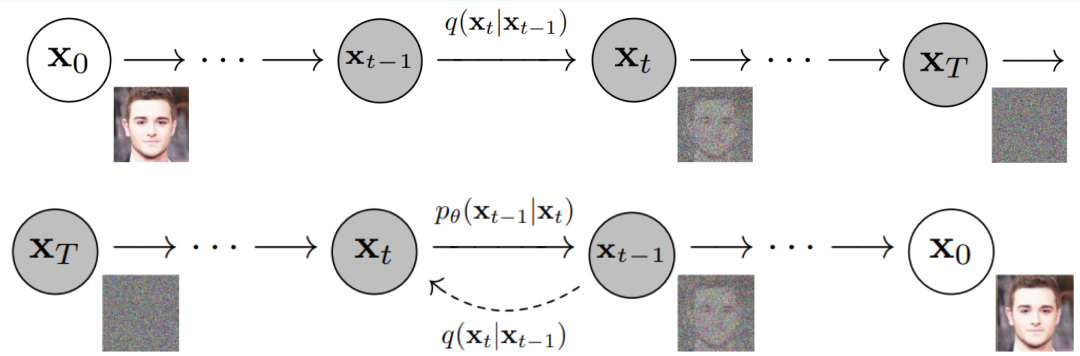

当前除语言模子外,天生式AI领域的其他希望还包罗图像天生模子等等。未来,多模态(文本、图、视频等)对齐、融合、明晰和天生等偏向的希望,意义也异常重大。

关于图像天生模子,不得不提的是扩散模子(Diffusion Model)。它主要解决通过文本天生图像及其他媒体名堂的难题,业内着名的扩散模子包罗:DALIE2、Stable Diffusion等。

图片泉源:Denoising Diffusion Probabilistic Models

/ 06 /

天生式AI相关的6点创业思索与建议

2022年,大语言模子发作。据统计,2022年,平均每4天就有一个新的大语言模子问世。

天生式AI手艺也在延续引发人们对一些着名的模子层平台和应用的接见,数据增进很快,投资火热。2019 年至2021年时代,流向天生式AI营业的资源增添了约130%,其中文本和写作增进630%、图像增进400%、数据增进 370% 、音频/视频增进350% 。

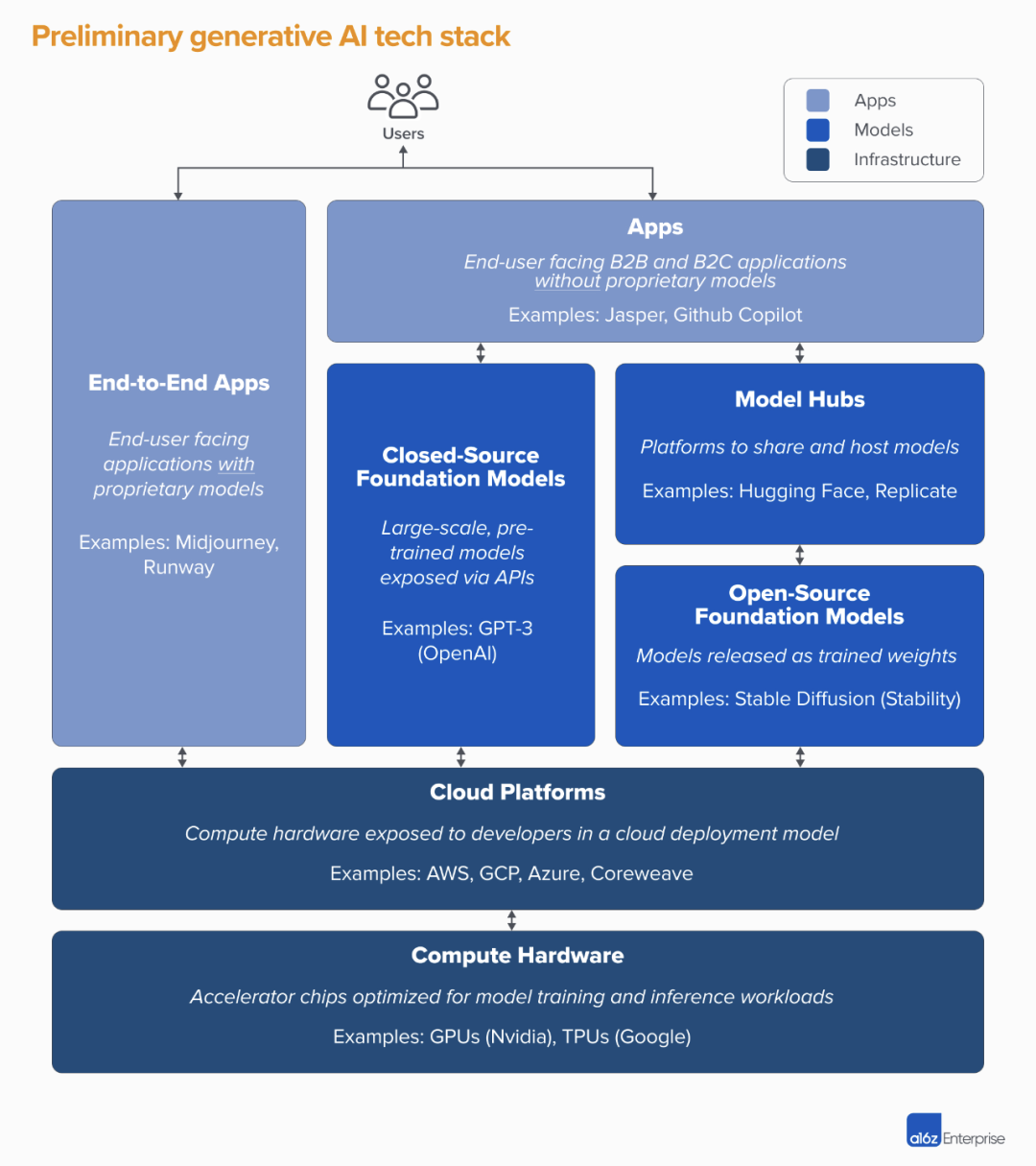

图片泉源:A16Z

上图是投资公司A16Z总结的天生式AI的行业客栈。底层深蓝色的部门是基础硬件和云平台,中央蓝色的部门是模子层,再往上浅蓝色的部门是应用层。

在应用层,有的创业公司自身只做应用,模子能力则是挪用外部的;尚有一类叫端到端的应用模式,它会自己做模子,但一样平常不做大模子,或者在其他大模子基础上微调出自己的模子。

在模子层,有开源模子和闭源模子。深蓝色部门的Model hubs是用于模子存储和训练的第三方平台。

当前应用层的增进对照快,主要是由AI赋能的新型应用案例所驱动,主要集中在图像天生、文案写作和代码编写,三个种别各自的年收入已超1亿美元。

关于天生式AI的创业,我有6点思索和建议:

*,现在,与AI相关的科研、工程、产物和商业化,都在同时快速迭代,变数很大。这个历程中,会泛起差其余手艺分支和营业路径,若是选错了手艺分支和营业路径,再掉头就很贫苦。这就需要创业团队既懂手艺又懂营业,在创业初期起劲做出准确选择。

第二,对创业公司而言,从应用层或者端到端的应用层切入,可能是相对能降低风险的做法。模子层有少量时机,但纷歧定适合大部门的创业者。第三,应用层在做商业模子设计的时刻,要小心模子层的界线。

以Jasper公司为例。2020年在GPT-3模子基础上,Jasper衍生出付费商业文本写作的商业模式。到了2022年底,ChatGPT向用户免费开放,给Jasper带来较大的压力。只管OpenAI未必会以商业文本天生作为自己的主要商业模式,但它一致赋能了入场的其他竞争者。Jasper需要展现出有竞争力的手艺积累与营业纵深,才气稳住脚跟。

第四,把AI手艺应用到产业场景,可分为新模式和旧模式刷新两类方式。新模式是指缔造之前没有的全新的应用场景,旧模式刷新则指在现有产业场景里用AI手艺来刷新部门环节,或者团队带着深度行业认知和新的AI手艺在成熟的产业场景中创业。新模式和旧模式刷新,都存在伟大的时机。

在峰瑞已投企业中,有好几家企业在垂直产业的场景中做营业创新。好比线上心理咨询平台阁楼、短视频及直播SAAS服务企业特看科技、线上健身私教平台BodyPark,都在努力使用天生式AI来赋能自己的营业。本周六(3月11日),我们将约请这3家公司的首创人来分享他们的探索和发现,迎接介入。

第五,AI还面临科研知识快速溢出的问题,因此找到自己的壁垒很主要。创业公司一定要想清晰自己未来的壁垒在那里,好比到底是数据壁垒、工程壁垒(例如模子微调)、场景壁垒,照样规模壁垒等等。在应用层创业,仅依赖外部模子层提供的能力,是无法形成壁垒的。

第六,应用层的创业,应该是“手艺为先、场景为重”。

“手艺为先”,是指虽然通用AI手艺未必是你的焦点壁垒,但团队一定要懂手艺,才有能力思索若何更早更好地把手艺应用到合适的应用场景里,做出好用的产物。

“场景为重”,意味着最后的产物和营业需要找到合适的落地场景,确立自己的商业模式,并在场景里形成自己的焦点竞争力。

/ 07 /

天生式AI行业的未来名目展望和意料

最厥后聊聊对AI行业名目的未来展望和意料。这个部门我参考了奇绩创坛陆奇博士之前的一个思索框架。

以AI和大模子为中央的新IT

新的硅基硬件产业:硅基产业架构和聚集可能迎来新的生长时机(例如:新的盘算芯片及周边手艺和产业等)。

新的软件和云服务系统:算力、模子和数据的云服务、基础软件、ML&Dev Ops、人机相助编程工具等。

新的基础智能终端装备:智能传感器、新型手机等

未来的智能终端会越来越智能,最近苹果公司官宣支持Stable Diffusion图像天生模子在iPad等终端上运行,也有工程师把经由裁剪的Stable Diffusion应用在iPhone上运行起来,可以预见以后我们的手机美颜和照片天生可以到达何等入迷入化的境界。

此外,当前的翻译软件手艺,在语义明晰方面照样对照浅,翻译质量差强人意。若是可以把类似ChatGPT这样的语言模子能力嵌入到智能终端中去,随着文本和语音的实时翻译成为可能,跨语言交流将变得很利便,这对于提升人类之间的交流效率意义重大。

▍围绕内容创作睁开的产业

文、图、视频、3D等种种媒体名堂的AI内容创作工具,是当前可以看到创业时机较多的新产业。

以ChatGPT为代表的语言模子的文本天生手艺,和以扩散模子为代表的图像视频多模态天生手艺,可能会对内容产业发生深远的影响。从PGC到UGC,再到现在的AIGC,内容领域会有更多新转变与新玩法。

从媒体行业生长情形来看,当前头部的内容媒体平台好比抖音快手B站是所谓的Web2.0平台,普遍接纳UGC方式为主来生产内容,然则随着AI生产内容(AIGC)的泛起,AI可以天生大量优异内容,成本较低、效果优良,而且甚至不乏创意,这个情形下内容媒体平台和行业就有可能泛起较大的转变。

围绕语言模子睁开的产业

在这个领域,新的时机可能包罗:语言学习范式改变,重塑跨语言相同方式,更友好的人机界面等。

其中稀奇值得一提的,是语言学习范式的改变。如前文所述,若是我们可以打开语言模子,从中寻找到语言学习的纪律,说不定可以辅助我们更有用率地学习语言。事实上,OpenAI投资了一家韩国的英语学习APP叫Speak。从有限的果然信息来看,这家公司未来的产物是一个语言学习助手,或者叫做虚拟语言先生——借助语言模子的能力和发现的语言纪律,去辅助人们更好地学习外语,而且成本极低。

跨语言相同的手艺现在还不成熟。如前面所说,若是我们能够把语言模子加载到智能终端,可能会极大改善跨语言相同的能力。

由于语言模子足够壮大,未来我们的人机界面,会接纳更友好的自然语言人机界面,无论是跟APP对话照样跟智能硬件对话。

围绕头脑模子睁开的产业

不妨畅想一下,更伶俐的软件(或机械人)、科研服务、 “知识工程”、“天下大脑”等。

当前的软件产业,即便有AI的加持,通用性和智能水平照样不尽如人意的,大多数情形下只能做一些特定的义务,只能成为人类的效率助手;随着加倍通用的AI能力泛起,软件也可以像人类一样思索和做事,可以想象软件就可以辅助人类承接较为完整的义务了。

若是AI可以生长出靠近人类的头脑能力,它也允许以成为人类科学家的科研助手,由于AI可以不知疲倦,且可普遍使用。当前,我们很难想象AI可以到达人类*科学家的水平。打个譬喻,你让它去证实下哥德巴赫意料,应该照样很不现实的。固然也有其他可能,如前文所述,若是AI程序可以实现自我优化,具备迭代自己的算法和手艺的能力,信托它的智能会很快遇上来。

若是我们睁开想象,就可以有更多的可能性。例如“知识工程”,若是把人类的知识建模,然后让人类以某种方式可以挪用或者学习,那么就不用经由“痛苦”的学习历程。“天下大脑”,是指规模极大的头脑模子,它可以辅助我们执行种种主要的盘算和思索。不外,若是真的生长到这个境界,可能离影戏《黑客帝国》里边的Matrix就不远了。

赋强人类,深入改变各行各业(稀奇是知识事情者)

语言是人类最主要的相同方式,是知识和头脑的主要载体;而深度头脑是人类的高阶能力,也是人类差异于其他物种的最主要的能力。若是AI掌握了这两种能力,就基本具备了在某种水平上赋能或替换一部门人类知识事情者的可能。

类似于自动化生产制造装备赋能传统工业,种种AI模子和应用软件也将有时机更好地赋能各行各业。然则差异于制造行业,大批量使用的软件,其边际使用成本是异常低的,而且它很伶俐、善学习、会思索、会交流,应该会有大量的应用场景有待开发。这里边有异常多的创业时机,也会给各行各业带来新的生长动力。

/ 08 /

写在最后,

为什么AIGC不会是短期风口?

首先,ChatGPT是语言模子领域的重大希望,鉴于语言对人类相同和头脑的重大意义,语言模子自己具备很强的通用性,以及人类可以通过研究语言模子获取语言及知识的学习纪律并获得效率提升,这些都市延续带来耐久的创新时机。

第二,AI在头脑机械这个偏向上尚有更远的路可以走。例如,若是AI能够实现优越的多模态信息输入,增添对物理天下的明晰,可能可以“涌现”出更多的智能。这个偏向的任何提高都意义重大。

第三,与AIGC相关的底层手艺原理和算法都还处在生长早期,未来尚有很长的迭代和优化时机。

一切,才刚刚最先。